Henry e Jane Evans estão habituados a convidados estranhos. Durante mais de uma década, o casal, que vive em Los Altos Hills, Califórnia, recebeu uma série de robôs na casa deles.

Em 2002, aos 40 anos, Henry teve um AVC fulminante, que o deixou tetraplégico e incapaz de falar. Desde então, aprendeu a comunicar movendo os olhos sobre um quadro de letras, mas depende muito dos prestadores de cuidados e da sua mulher, Jane.

Henry teve um vislumbre de um tipo de vida diferente quando viu Charlie Kemp na CNN em 2010. Kemp, professor de robótica na Georgia Tech, estava na televisão a falar sobre o PR2, um robô desenvolvido pela empresa Willow Garage. O PR2 era uma máquina de dois braços sobre rodas que parecia um mordomo de metal rudimentar. Kemp estava a demonstrar o funcionamento do robô e a falar da sua investigação sobre como os robôs de cuidados de saúde podem ajudar as pessoas. Mostrou como o robô PR2 podia entregar alguns medicamentos ao apresentador de televisão.

De repente, o Henry vira-se para mim e diz: “Por que é que aquele robô não pode ser uma extensão do meu corpo? E eu disse: “Por que não?””. conta Jane.

Havia uma razão sólida para não o fazer. Embora os engenheiros tenham feito grandes progressos no sentido de pôr os robôs a trabalhar em ambientes rigorosamente controlados, como laboratórios e fábricas, tem sido difícil conceber robôs para o lar. No mundo real e desarrumado, a mobília e as plantas dos pisos são muito diferentes; as crianças e os animais de estimação podem saltar no caminho do robô; e a roupa que precisa de ser dobrada tem diferentes formas, cores e tamanhos. Gerir estes cenários imprevisíveis e condições variadas tem estado para além das capacidades até dos protótipos de robôs mais avançados.

Isso parece estar finalmente a mudar, em grande parte graças à Inteligência Artificial. Durante décadas, os especialistas em robótica têm-se concentrado mais ou menos no controlo dos “corpos” dos robôs – os seus braços, pernas, alavancas, rodas e afins – através de software orientado para fins específicos. Mas uma nova geração de cientistas e inventores acredita que o ingrediente que faltava na IA pode dar aos robôs a capacidade de aprender novas competências e de se adaptarem a novos ambientes mais rapidamente do que nunca. Esta nova abordagem, talvez, possa finalmente trazer os robôs para fora da fábrica e para as nossas casas.

No entanto, o progresso não acontecerá de um dia para o outro, como os Evans sabem muito bem, devido aos seus muitos anos de utilização de vários protótipos de robôs.

O PR2 foi o primeiro robô que trouxeram e abriu novas possibilidades para Henry. O PR2 segurava uma máquina de barbear e Henry movia o rosto contra ela, permitindo-lhe fazer a barba e coçar uma comichão sozinho pela primeira vez numa década. Mas, com cerca de 200 quilos e 400 mil dólares, era difícil ter o robô por perto. “Podia facilmente destruir uma parede da sua casa”, diz Jane. “Eu não era uma grande fã.”

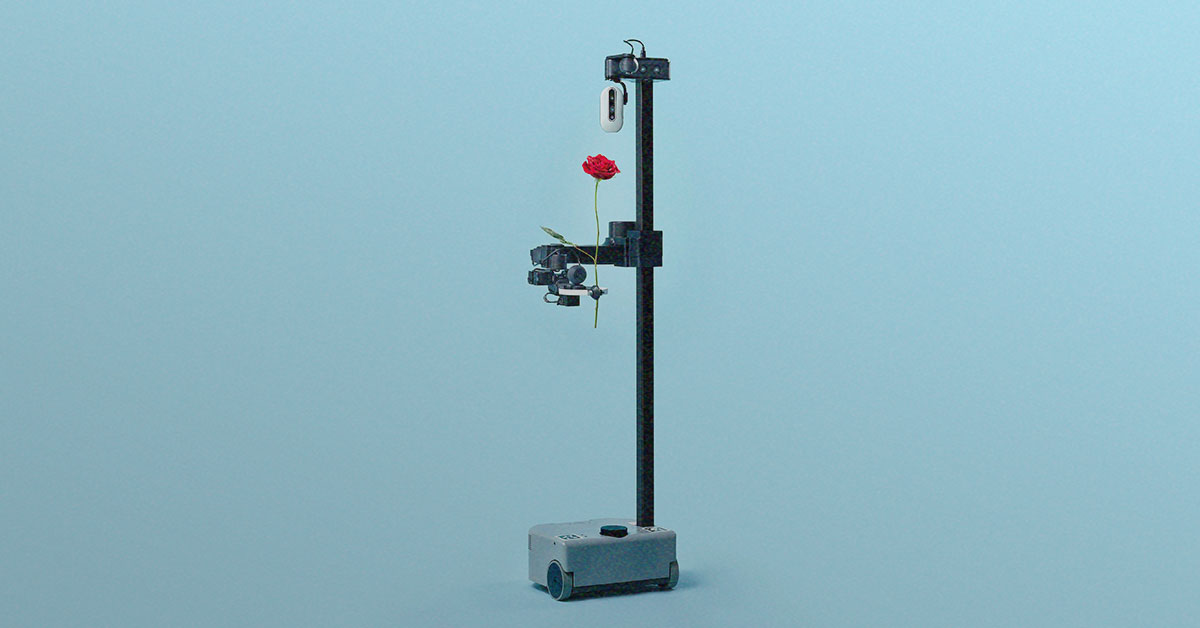

Mais recentemente, os Evans têm estado a testar um robô menor chamado Stretch, que Kemp desenvolveu através da sua empresa Hello Robot. A primeira versão foi lançada durante a pandemia com um preço mais razoável de cerca de 18 mil dólares.

O Stretch pesa cerca de 15 quilos. Tem uma pequena base móvel, um bastão com uma câmara pendurada e um braço ajustável com uma pinça com ventosas nas extremidades. Pode ser controlado com um comando de consola. Henry controla o Stretch utilizando um computador portátil, com uma ferramenta que segue os movimentos da sua cabeça para mover um cursor. É capaz de mover o polegar e o indicador o suficiente para clicar num rato de computador. No verão passado, Stretch esteve com o casal durante mais de um mês, e Henry diz que isso lhe deu um novo nível de autonomia. “Era prático e eu via-o a ser utilizado todos os dias”, diz.

Utilizando o seu notebook, conseguiu que o robô lhe escovasse o cabelo e que lhe segurasse frutas para ele comer. Também abriu a relação de Henry com a sua neta Teddie. Antes, os dois quase não interagiam. “Ela nem sequer o abraçava na despedida. Nada disso”, diz Jane. Mas “Papa Wheelie” e Teddie usaram Stretch para brincar, participando em corridas, bowling e pesca magnética.

O Stretch não tem muita inteligência: vem com algum software pré-instalado, como a interface Web que Henry utiliza para o controlar, e outras capacidades, como a navegação com IA. A principal vantagem do Stretch é que as pessoas podem ligar os seus próprios modelos de IA e utilizá-los para fazer experiências. Mas oferece um vislumbre do que poderá ser um mundo com robôs domésticos úteis. Os robôs que podem fazer muitas das coisas que os humanos fazem em casa – tarefas como dobrar a roupa, cozinhar refeições e limpar – têm sido um sonho da investigação em robótica desde o início da área na década de 1950. Durante muito tempo, não passou disso mesmo: “A robótica está cheia de sonhadores”, diz Kemp.

Mas o campo está num ponto de inflexão, diz Ken Goldberg, professor de robótica na Universidade da Califórnia, em Berkeley. Os esforços anteriores para construir um robô doméstico útil, diz ele, falharam redondamente em satisfazer as expectativas estabelecidas pela cultura popular – pense na empregada robótica de Os Jetsons. Atualmente, as coisas são muito diferentes. Graças a hardware barato como o Stretch, juntamente com os esforços para recolher e partilhar dados e os avanços na IA generativa, os robôs estão a tornar-se mais competentes e úteis mais rapidamente do que nunca. “Estamos num ponto em que estamos muito perto de obter capacidades que vão ser realmente úteis”, diz Goldberg.

Dobrar a roupa, cozinhar camarão, limpar superfícies, descarregar cestos de compras – os robôs actuais alimentados por IA estão a aprender a fazer tarefas que, para os seus antecessores, teriam sido extremamente difíceis.

Peças em falta

Há uma observação bem conhecida entre os especialistas em robótica: o que é difícil para os humanos é fácil para as máquinas, e o que é fácil para os humanos é difícil para as máquinas. Chamado paradoxo de Moravec, foi articulado pela primeira vez na década de 1980 por Hans Moravec, especialista do Instituto de Robótica da Universidade Carnegie Mellon. Um robô pode jogar xadrez ou manter um objeto imóvel durante horas sem qualquer problema. Amarrar um atacador, apanhar uma bola ou ter uma conversa é outra questão.

Há três razões para isso, diz Goldberg. Em primeiro lugar, os robôs não têm um controlo e uma coordenação precisos. Em segundo lugar, a sua compreensão do mundo que os rodeia é limitada porque dependem de câmaras e sensores para o perceber. Em terceiro lugar, falta-lhes um sentido inato de física prática.

“Pegue num martelo e ele provavelmente cairá da sua mão, a menos que o agarre perto da parte pesada. Mas não sabemos isso se olharmos para ele, a não ser que saibamos como funcionam os martelos”, diz Goldberg.

Para além destas considerações básicas, há muitos outros aspectos técnicos que têm de ser correctos, desde motores a câmaras e ligações Wi-Fi, e o hardware pode ser proibitivamente caro.

Mecanicamente, já há algum tempo que conseguimos fazer coisas bastante complexas. Num vídeo de 1957, dois grandes braços robóticos têm destreza suficiente para tragar um cigarro, colocá-lo na boca de uma mulher à máquina de escrever e voltar a aplicar-lhe batom. Mas a inteligência e a consciência espacial desse robô provinham da pessoa que o operava.

“A peça que falta é: como é que conseguimos que o software faça [estas coisas] automaticamente?”, diz Deepak Pathak, professor assistente de ciências informáticas na Carnegie Mellon.

Tradicionalmente, os investigadores que treinam robôs têm abordado este problema planejando tudo o que o robô faz com um detalhe extremo. O gigante da robótica Boston Dynamics utilizou esta abordagem quando desenvolveu o seu robô humanoide Atlas, que faz boogying e parkour. As câmaras e a visão por computador são utilizadas para identificar objectos e cenas. Os investigadores utilizam então esses dados para criar modelos que podem ser utilizados para prever com extrema precisão o que acontecerá se um robô se mover de uma determinada forma. Utilizando estes modelos, os especialistas planejam os movimentos das suas máquinas, escrevendo uma lista muito específica de acções a realizar. Os engenheiros testam depois estes movimentos em laboratório muitas vezes e ajustam-nos até à perfeição.

“O LADO MAIS LEVE DAS NOTÍCIAS — ROBÔ ATÓMICO UM HOMEM ÚTIL” (1957) VIA YOUTUBE

Esta abordagem tem os seus limites. Os robôs treinados desta forma são estritamente coreografados para trabalhar num ambiente específico. Se os levarmos para fora do laboratório e para um local desconhecido, é provável que caiam.

Em comparação com outros domínios, como a visão por computador, a robótica tem estado na idade das trevas, diz Pathak. Mas isso pode não ser o caso por muito mais tempo, porque o campo está a sofrer uma grande mudança. Graças ao boom da IA, diz ele, o foco está agora a mudar de proezas de destreza física para a construção de “cérebros robóticos de uso geral” sob a forma de redes neurais. Tal como o cérebro humano é adaptável e pode controlar diferentes aspectos do corpo humano, estas redes podem ser adaptadas para funcionar em diferentes robôs e diferentes cenários. Os primeiros sinais deste trabalho revelam resultados prometedores.

Os robôs e a IA

Durante muito tempo, a investigação em robótica foi um campo implacável, atormentado por um progresso lento. No Instituto de Robótica da Carnegie Mellon, onde Pathak trabalha, diz ele, “costumava dizer-se que se tocássemos num robô, acrescentávamos um ano ao nosso doutorado”. Agora, diz ele, os estudantes são expostos a muitos robôs e vêem resultados numa questão de semanas.

O que distingue esta nova geração de robôs é o seu software. Em vez do tradicional planejamento e treino meticulosos, os criadores começaram a utilizar deep learning e as redes neuronais para criar sistemas que aprendem com o seu ambiente em movimento e ajustam o seu comportamento em conformidade. Ao mesmo tempo, hardware novo e mais barato, como componentes prontos a usar e robôs como o Stretch, está a tornar este tipo de experiências mais acessível.

Em termos gerais, há duas formas populares de os investigadores utilizarem a IA para treinar robôs. Pathak tem utilizado a aprendizagem por reforço, uma técnica de IA que permite que os sistemas melhorem através de tentativa e erro, para fazer com que os robôs adaptem os seus movimentos a novos ambientes. Esta é uma técnica que a Boston Dynamics também começou a utilizar nos seus “cães” robôs chamados Spot.

Em 2022, a equipa de Pathak utilizou este método para criar “cães” robôs de quatro patas capazes de subir degraus e navegar em terrenos complicados. Os robôs foram primeiro treinados para se movimentarem de uma forma geral num simulador. Depois, foram soltos no mundo real, com uma única câmara incorporada e um software de visão por computador para os guiar. Outros robôs semelhantes baseiam-se em mapas internos do mundo rigorosamente prescritos e não conseguem navegar para além deles.

Pathak diz que a abordagem da equipa foi inspirada na navegação humana. Os humanos recebem informações sobre o mundo que os rodeia através dos olhos, o que os ajuda a colocar instintivamente um pé à frente do outro para se deslocarem de forma adequada. Normalmente, os humanos não olham para o chão debaixo dos pés quando andam, mas sim para alguns passos à frente, para o local para onde querem ir. A equipa de Pathak treinou os seus robôs para adoptarem uma abordagem semelhante ao caminhar: cada um deles utilizou a câmara para olhar em frente. O robô foi então capaz de memorizar o que estava à sua frente durante o tempo suficiente para orientar a colocação das suas pernas. Os robôs aprenderam sobre o mundo em tempo real, sem mapas internos, e ajustaram o seu comportamento em conformidade. Na altura, os especialistas disseram à MIT Technology Review que a técnica era um “avanço na aprendizagem e autonomia dos robôs” e que poderia permitir aos investigadores construir robôs com pernas capazes de serem utilizados na natureza.

Os cães-robô de Pathak subiram de nível desde então. O último algoritmo da equipa permite que um robô quadrúpede faça parkour extremo. O robô foi novamente treinado para se movimentar de uma forma geral numa simulação. Mas, utilizando a aprendizagem por reforço, foi capaz de ensinar a si próprio novas competências em movimento, tais como saltar longas distâncias, andar sobre as patas dianteiras e trepar a caixas altas com o dobro da sua altura. Estes comportamentos não foram programados pelos investigadores. Em vez disso, o robô aprendeu por tentativa e erro e através de informações visuais da sua câmara frontal. “Não acreditava que fosse possível há três anos”, diz Pathak.

Na outra técnica popular, designada por aprendizagem por imitação, os modelos aprendem a executar tarefas, por exemplo, imitando as acções de um humano que teleopera um robô ou utilizando um auricular de realidade virtual para recolher dados sobre um robô. Trata-se de uma técnica que entrou e saiu de moda ao longo de décadas, mas que se tornou recentemente mais popular entre os robôs que realizam tarefas de manipulação, afirma Russ Tedrake, vice-presidente de investigação em robótica do Toyota Research Institute e professor do MIT.

Ao associar esta técnica à IA generativa, os investigadores do Instituto de Investigação da Toyota, da Universidade de Columbia e do MIT conseguiram ensinar rapidamente os robôs a realizar muitas tarefas novas. Acreditam ter encontrado uma forma de alargar a tecnologia que impulsiona a IA generativa do domínio do texto, das imagens e dos vídeos para o domínio dos movimentos dos robôs.

A ideia é começar com um humano, que controla manualmente o robô para demonstrar comportamentos como bater ovos ou pegar em pratos. Utilizando uma técnica chamada política de difusão, o robô é então capaz de utilizar os dados que lhe são fornecidos para aprender competências. Os investigadores já ensinaram aos robôs mais de 200 competências, como descascar legumes e verter líquidos, e dizem que estão a trabalhar para ensinar mil competências até ao final do ano.

Muitos outros também aproveitaram a IA generativa. A Covariant, uma empresa de robótica que nasceu da unidade de investigação de robótica da OpenAI, agora encerrada, criou um modelo multimodal chamado RFM-1. Pode aceitar avisos sob a forma de texto, imagem, vídeo, instruções do robô ou medições. A IA generativa permite que o robô compreenda as instruções e gere imagens ou vídeos relacionados com essas tarefas.

A equipa do Toyota Research Institute espera que um dia isto conduza a “grandes modelos de comportamento”, que são análogos a grandes modelos de linguagem, diz Tedrake. “Muitas pessoas pensam que a clonagem de comportamentos nos vai levar a um momento de ChatGPT para a robótica”, diz.

Numa demonstração semelhante, no início deste ano, uma equipa de Stanford conseguiu utilizar um robô relativamente barato, que custava 32 mil dólares, para realizar tarefas de manipulação complexas, como cozinhar camarão e limpar manchas. Aprendeu rapidamente essas novas competências com a IA.

Chamado Mobile ALOHA (um acrónimo informal para “sistema de teleoperação de hardware de código aberto e baixo custo”), o robô aprendeu a cozinhar camarão com a ajuda de apenas 20 demonstrações humanas e dados de outras tarefas, como arrancar uma toalha de papel ou um pedaço de fita adesiva. Os investigadores de Stanford descobriram que a IA pode ajudar os robôs a adquirir competências transferíveis: o treino numa tarefa pode melhorar o seu desempenho em outras.

Tudo isto está a lançar as bases para robôs que podem ser úteis nas casas. As necessidades humanas mudam ao longo do tempo e é importante ensinar os robôs a executar uma vasta gama de tarefas, pois isso irá ajudar a adaptarem-se a nós. Isto também é importante para a comercialização – a primeira geração de robôs domésticos terá um preço elevado e os robôs precisam de ter competências úteis suficientes para que os consumidores comuns queiram investir neles.

Durante muito tempo, grande parte da comunidade robótica foi muito cética em relação a este tipo de abordagens, afirma Chelsea Finn, professora assistente de ciências informáticas e engenharia eléctrica na Universidade de Stanford e consultora do projeto Mobile ALOHA. Finn afirma que, há cerca de uma década, as abordagens baseadas na aprendizagem eram raras nas conferências de robótica e desacreditadas na comunidade robótica. “O boom do [processamento de linguagem natural] tem convencido mais a comunidade de que esta abordagem é realmente, realmente poderosa”, afirma.

No entanto, há um senão. Para imitar novos comportamentos, os modelos de IA precisam de muitos dados.

Mais é mais

Ao contrário dos chatbots, que podem ser treinados utilizando milhares de milhões de pontos de dados recolhidos da Internet, os robôs precisam de dados criados especificamente para robôs. Precisam de demonstrações físicas de como as máquinas de lavar roupa e os frigoríficos são abertos, a loiça é recolhida ou a roupa é dobrada, diz Lerrel Pinto, professor assistente de ciências informáticas na Universidade de Nova Iorque. Atualmente, esses dados são muito escassos e os humanos demoram muito tempo a recolhê-los.

Alguns investigadores estão a tentar utilizar vídeos existentes de humanos a fazer coisas para treinar robôs, esperando que as máquinas consigam copiar as acções sem necessidade de demonstrações físicas.

O laboratório de Lerrel também desenvolveu uma abordagem de recolha de dados simples e barata que liga os movimentos robóticos às acções desejadas. Os investigadores pegaram um objeto semelhante aos utilizados para apanhar lixo e ligaram em um iPhone.

Os voluntários humanos podem usar este sistema para filmarem a si próprios a fazer tarefas domésticas, imitando a visão do robô da extremidade do seu braço robótico. Utilizando este substituto do braço robótico do Stretch e um sistema de código aberto chamado DOBB-E, a equipa de Lerrel conseguiu que um robô Stretch aprendesse tarefas como servir-se de um copo e abrir cortinas de duche com apenas 20 minutos de dados do iPhone.

Mas para tarefas mais complexas, os robôs precisariam de ainda mais dados e mais demonstrações.

A escala necessária seria difícil de atingir com o DOBB-E, diz Lerrel, porque basicamente seria necessário persuadir todos os seres humanos da Terra a comprar o sistema de recolha de dados e a carregá-los para a Internet.

Uma nova iniciativa lançada pela Google DeepMind, denominada Open X-Embodiment Collaboration, tem como objetivo mudar isso. No ano passado, a empresa estabeleceu uma parceria com 34 laboratórios de investigação e cerca de 150 investigadores para recolher dados de 22 robôs diferentes, incluindo o Stretch do Hello Robot. O conjunto de dados resultante, que foi publicado em outubro de 2023, consiste em robôs que demonstram 527 competências, tais como pegar, empurrar e deslocar-se.

Sergey Levine, um cientista informático da Universidade da Califórnia em Berkeley que participou no projeto, afirma que o objetivo era criar uma “Internet dos robôs” através da recolha de dados de laboratórios de todo o mundo. Deste modo, os investigadores teriam acesso a conjuntos de dados maiores, mais escaláveis e mais diversificados. A revolução da aprendizagem profunda que conduziu à IA generativa dos nossos dias começou em 2012 com o surgimento do ImageNet, um vasto conjunto de dados online de imagens. A Open X-Embodiment Collaboration é uma tentativa da comunidade robótica de fazer algo semelhante com os dados dos robots.

Os primeiros sinais mostram que mais dados estão a conduzir a robôs mais inteligentes. Os investigadores construíram duas versões de um modelo para robôs, denominado RT-X, que pode ser executado localmente em computadores de laboratórios individuais ou acedido através da Web. O modelo maior foi pré-treinado com dados da Internet para desenvolver um “sentido comum visual”, ou uma compreensão básica do mundo, a partir dos modelos de linguagem e imagem de grande dimensão.

Quando os investigadores utilizaram o modelo RT-X em muitos robôs diferentes, descobriram que os robôs eram capazes de aprender competências com 50% mais êxito do que nos sistemas que cada laboratório estava a desenvolver individualmente.

“Acho que ninguém estava à espera disto”, afirma Vincent Vanhoucke, diretor de robótica da Google DeepMind. “De repente, há um caminho para aproveitar basicamente todas estas outras fontes de dados para criar comportamentos muito inteligentes na robótica.”

Muitos especialistas em robótica pensam que os grandes modelos de visão-linguagem, capazes de analisar dados de imagem e de linguagem, podem oferecer aos robôs pistas importantes sobre o funcionamento do mundo que os rodeia, diz Vanhoucke. Oferecem pistas semânticas sobre o mundo e podem ajudar os robots a raciocinar, a deduzir coisas e a aprender através da interpretação de imagens. Para testar isto, os investigadores pegaram num robô que tinha sido treinado com o modelo maior e pediram-lhe para apontar para uma fotografia da Taylor Swift. Os investigadores não mostraram ao robô fotografias de Swift, mesmo assim ele conseguiu identificar a estrela pop porque tinha uma compreensão à escala da Web de quem ela era, mesmo sem fotografias dela no seu conjunto de dados, diz Vanhoucke.

Vanhoucke diz que a Google DeepMind está a utilizar cada vez mais técnicas semelhantes às que utilizaria na tradução automática para traduzir do inglês para a robótica. No verão passado, a Google introduziu um modelo de visão-linguagem-ação chamado RT-2. Este modelo obtém a sua compreensão geral do mundo a partir de textos e imagens online com que foi treinado, bem como das suas próprias interacções no mundo real. Traduz esses dados em acções robóticas. Cada robô tem uma forma ligeiramente diferente de traduzir o inglês em acções, acrescenta.

“Cada vez mais sentimos que um robô é essencialmente um chatbot que fala robotês”, afirma Vanhoucke.

Passos pequenos

Apesar do ritmo acelerado de desenvolvimento, os robôs ainda enfrentam muitos desafios antes de poderem ser lançados no mundo real. Ainda são desajeitados para que os consumidores comuns justifiquem gastar dezenas de milhares de dólares neles. Os robôs também ainda não têm o tipo de senso comum que lhes permitiria realizar várias tarefas. E precisam de passar de apenas pegar nas coisas e colocá-las num sítio para juntar as coisas, diz Goldberg – por exemplo, colocar um baralho de cartas ou um jogo de tabuleiro de volta na sua caixa e depois no armário dos jogos.

Mas a julgar pelos primeiros resultados da integração da IA nos robôs, os especialistas em robótica não estão a perder o seu tempo, diz Lerrel.

“Sinto-me bastante confiante de que veremos uma espécie de robô doméstico de uso geral. Mas será que vai ser acessível ao público em geral? Não me parece”, diz. “Mas, em termos de inteligência bruta, já estamos a ver sinais neste momento”.

A construção da próxima geração de robôs pode não se limitar a ajudar os humanos nas suas tarefas quotidianas ou a ajudar pessoas como Henry Evans a viver uma vida mais independente. Para investigadores como Lerrel Pinto, há um objetivo ainda maior em vista.

Para Henry e Jane Evans, uma grande vitória seria obter um robô que simplesmente funcionasse de forma fiável. O robô Stretch que os Evans experimentaram ainda tem demasiados bugs para ser utilizado sem a presença de investigadores para resolver problemas, e a sua casa nem sempre tem a conetividade Wi-Fi fiável de que Henry precisa para comunicar com o Stretch utilizando um computador portátil.

Mesmo assim, diz Henry, um dos maiores benefícios da sua experiência com robôs tem sido a independência: “Tudo o que faço é estar deitado na cama e agora posso fazer coisas por mim próprio que envolvem a manipulação do meu ambiente físico”.

Graças ao Stretch, pela primeira vez em duas décadas, Henry foi capaz de segurar as suas próprias cartas de baralho para jogar durante uma partida.

“Dei um pontapé no traseiro de muita gente várias vezes”, diz ele.

“Não vamos falar muito alto”, diz Jane, e ri.